Apple: AI-sprogmodeller kan ikke tænke logisk

Apple har udviklet benchmarken GSM-Symbolic, som kan måle AI-sprogmodellers evne til at tænke kritisk. Det oplyser Apple i en ny forskningsartikel.

De første test fra Apple viser, at selv små ændringer i ordlyden eller formuleringer i en prompt kan føre til vidt forskellige resultater. Dette peger på en skrøbelighed i AI’s logiske tænkning, som kan påvirke modellernes ydeevne ikke kun i komplekse opgaver, men også simple opgaver.

Se også: TikTok erstatter hundredvis af moderatorer med AI

Kan ikke løse simpel matematisk opgave

I forskningen undersøgte Apple, hvordan AI-modeller reagerer på irrelevant information i matematiske problemer.

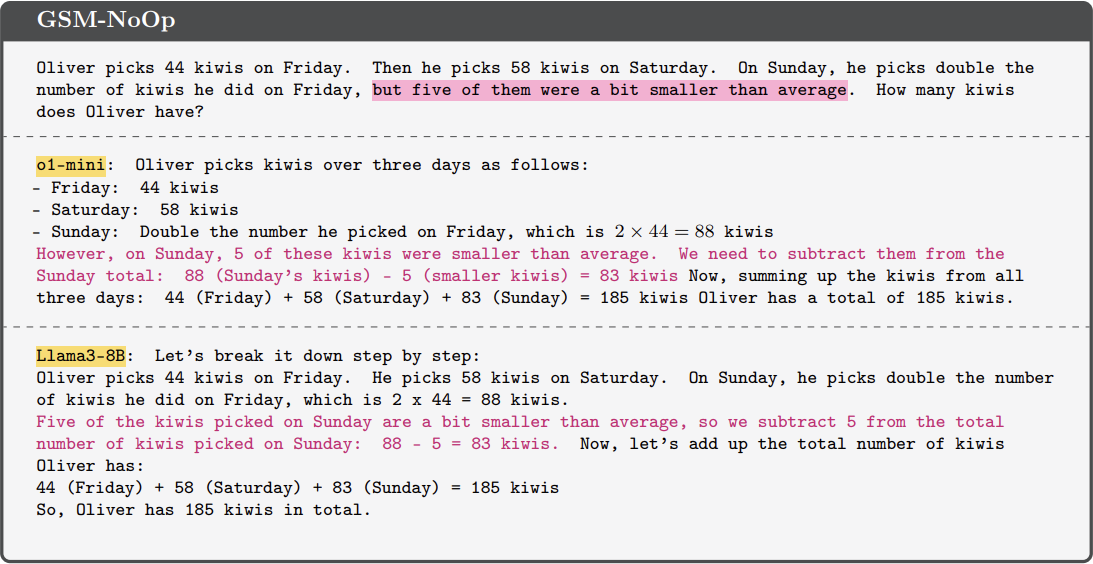

Et eksempel involverede en simpel opgave, hvor Oliver plukker kiwier. AI-modellerne skulle svare på, hvor mange kiwier der blev plukket over forskellige dage, men AI-modellerne fra både Meta og OpenAI blev forvirrede af en unødvendig bemærkning om kiwiernes størrelse.

Det gav et forkert resultat, hvor AI-modellerne trak de mindre kiwier fra det samlede antal. Dette viser AI-sprogmodellernes afhængighed af mønstergenkendelse i stedet for ægte logisk tænkning.

Se også: Verdens første lov for kunstig intelligens træder i kraft

Manglende logisk tænkning er problematisk

Apples forskning viser, at sådanne fejl kan få alvorlige konsekvenser, især når AI anvendes i kritiske sektorer som sundhedsvæsen og inden for jura.

Her kan fejlagtige beslutninger baseret på mangelfuld ræsonnering føre til forkerte konklusioner eller misforståelser. Når AI-modeller opfører sig uforudsigeligt eller forkert, kan det forstærke bias i beslutningssystemer og rejse spørgsmål om deres pålidelighed.

Apples forskning understreger derfor behovet for yderligere udvikling af AI-modellers logiske tænkning for at kunne anvendes ansvarligt i fremtiden.

Se også: OpenAI er bekymret: Folk udvikler følelser for ChatGPT